V této části bych se chtěl více věnovat použití NVMe technologie v prostředích Ethernet a InfiniBand (IB).

Kdy se stane NVMe dominantní technologií pro připojování serverů k storage zařízením? - část 2/2

Je jedna věc, kterou si mnozí IT manažeři a storage specialisté o technologii NVMe neuvědomují. Pokud si vezmeme celkový přínos NVMe pro zrychlení IO operací, tak výkonnostní přínos technologie NVMe pro zrychlení operací disků připojených na back-end představuje asi 20 %. Mnohem větší výhody NVMe, těch zbývajících 80 %, se projeví právě při použití technologie NVMe pro front-end konektivitu - při připojení storage zařízení k serverům. Proto není až tak důležité jaký je způsob připojení disků na backend diskového pole, ale jakým způsobem komunikuje diskové pole s připojenými servery.

Vylepšení v oblasti IOPS a propustnosti jsou primárně výsledkem flexibility NVMe a jeho schopnosti využít výhody rychlých transportních technologií pro přenos NVMe příkazů a dat. Tyto transportní technologie v současnosti zahrnují:

- RDMA protokol - RDMA (Remote Direct Memory Access) je způsob jak si vyměňovat data mezi hlavními pamětmi dvou serverů prostřednictvím sítě, bez nutnosti zapojení procesoru, paměti nebo operačního systému či jiného počítače. Jelikož RDMA obchází operační systém, je to obecně nejrychlejší mechanismus s nejnižší režií přenosu dat přes síť. V současnosti RDMA dokáže spolupracovat se dvěma technologiemi:

- o Data Center Ethernet: současné rychlosti 25, 40, 50, 100 Gbps.

- o InfiniBand: v současnosti jsou k dispozici rychlosti do 100 Gbps.

- PCI Expres 3.0: podporuje 8 gigatransfers za sekundu (GT / s). (GT / s představuje jednotku výkonu sběrnice. Číslo je bezrozměrný údaj, který říká kolikrát za sekundu je sběrnice schopna efektivně přenést data. Nemluví však o tom, o jak velký blok dat se jedná, protože to závisí na šířce sběrnice. Například 64bitová sběrnice při výkonu 1,6g / s je schopna přenést až 12,8GB / s, jedná se ale o maximální teoretický výkon bez započtení paritních dat pro opravu chyb, režie sběrnice apod.)

Vylepšení propustnosti jsou výsledkem masivní paralelizace činností prostřednictvím NVMe. Tato paralelizace umožňuje protokolu NVMe distribuovat zpracování přes několik procesorová jádra pro paralelní zpracovávání dat.

Vylepšení v oblasti zpoždění jsou výsledkem kombinace několika faktorů, včetně:

- přímočarého souboru NVMe příkazů

- nahrazení hardware přerušení (hardware interrupts) jinou technologií (polling mode driver)

- eliminací softwarových zámků

- odstranění kontextových přepínačů

Všechny tyto faktory společně ovlivňují propustnost a zkracují dobu odezvy, což jsou klíčové sledované parametry pro kritické business aplikace.

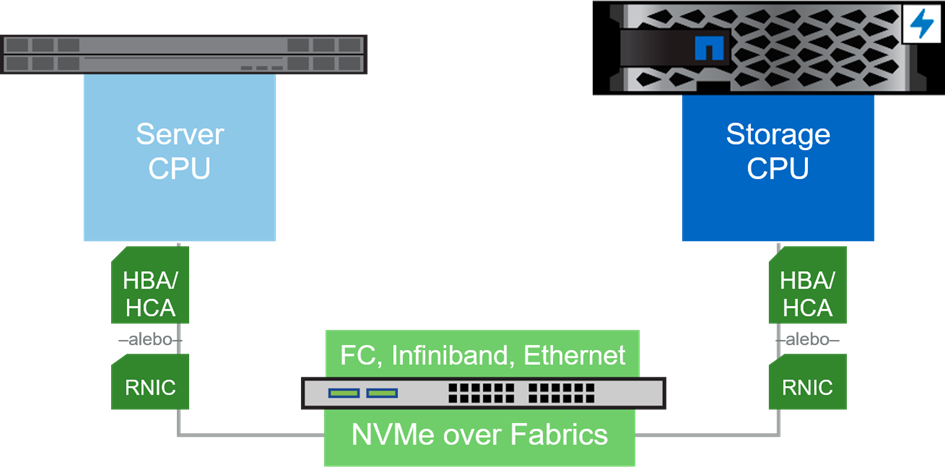

NVMe over Fabric (NVMe-oF)

NVMe-oF je primárně určen pro použití NVMe protokolu v datových sítích. Definuje architekturu přístupu a protokoly použité pro připojení serverů k blokovým storage zařízením. Nejjednodušší je si to představit jako způsob jak vylepšit současné blokové protokoly jako FCP a iSCSI.

NVMe-oF dodává specifikaci, základní standardy a modely, které mohou být použity pro NVMe transport uvnitř různých současných přenosových technologií jako například:

- NVMe / FC - pro detaily podívat první část článku na toto téma: link ZDE

- NVMe / TCP - NVMe přenášen v TCP datagram. NVMe / TCP je v současnosti tvořící se protokol (pracuje se na jeho definici), avšak má potenciál stát se nejpopulárnějším variantám NVMe přes Ethernet a zároveň protokolem, který by se mohl stát logickým pokračováním pro iSCSI protokol. Podobně jako iSCSI používá NVMe / TCP standardní NIC adaptéry (Network Interface Cards) a ethernetové přepínače, což z něj dělá atraktivní možnost pro prostředí, ve kterých chtějí zákazníci používat NVMe protokol bez speciálních zařízení jako jsou RDMA NICs (RNICs) a DCB (Data Center bridging) přepínače, které jsou potřebné pro podporu roce (RDMA over Converged Ethernet).

- NVMe s podporou RDMA. Existuje několik způsobů přenosu, které podporují RDMA:

- o NVMe přes Infiniband (NVMe / IB). Toto řešení používá Infiniband technologii, která v současnosti podporuje rychlosti do 100Gbps jako ultra rychlý způsob přenosu. I když se jedná o extrémně rychlý způsob komunikace, Infiniband je velmi drahá technologie a má omezení co se týče vzdálenosti propojení i škálování. Prvním diskovým polem v enterprise třídě s možností připojení NVMe / IB bylo diskové pole NetApp EF570, které je schopné poskytovat 1M IOPS a 21 Gbps s latencí menší než 100μs.

- o RDMA přes Ethernet připojení

- Internet Wide-Area RDMA Protocol (iWARP) přenáší RDMA s použitím Direct Data Placement protokolu (DDP), který je transportován použitím TCP nebo Secure TCP (STCP). DDP přenáší data v streamu a nesegmentuje jejich aby vyhovovaly rámcem TCP protokolu. NetApp používá iWARP protokol při MCC IP (Metrocluster IP) pro zrcadlení paměti mezi nodmi ve vzdálených lokalitách. Pro disková pole FAS2750 a AFF A220 se používá softwarový iWARP, pro ostatní modely diskových polí, které mají možnost osadit rozšiřující kartu jsou používány dedikované iWARP karty (2p 25GB iWARP SFP28 nebo 2p 100GbE iWARP QSFP28).

- RoCE (RDMA over Converged Ethernet) přenáší RDMA přes konvergovaný Ethernet, tím pádem nabízí nízké zpoždění protože nepotřebuje TCP. Na druhé straně roce vyžaduje Ethernet přepínače, které podporují Data Center Bridging (DCB) a Priority Flow Control (PFC) funkcionalitu. DCB přepínače nejsou standardními základními Ethernet přepínači a bývají obvykle dražší. Na serverech a storage kontroléry musí být osazen speciální síťový adaptér s podporou RDMA (RNIC). V současnosti existují dvě varianty ROCE:

- RoCE v1 definované původní specifikací, ve které protokol na úrovni linkové vrstvy L2 umožňuje komunikaci mezi iniciátorem a targetem v rámci téhož subnetu. Roce je tedy protokol na úrovni linkové vrstvy L2 a nemůže být směrován mezi různými L3 subnety.

- RoCE v2 je protokol definován na síťové vrstvě, který používá UDP (User Data Protocol) přes IPv4 nebo přes IPv6. Pracuje tedy na úrovni síťové vrstvy L3 a může být směrován mezi různými L3 subnety. Jelikož UDP nevyžaduje "in-order delivery" ale zároveň roce v2 specifikace nepovoluje "out-of-order delivery", musí být tento požadavek zajištěna na úrovni DCB sítě. Roce v2 také definuje flow-control mechanismus, který používá bity ECN (Explicit Congestion Notification) pro označování jednotlivých rámců a CNPS (Congestion Notification Packets) pro potvrzení doručení rámců.

- iSER- iSCSI Extension pro RDMA. iSeries je rozšíření pro iSCSI protokol pro podporu RDMA. RDMA může být potom realizována přes TCP s RDMA službami (iWARP), které dokáže použít stávající Ethernetové zařízení a nepotřebuje nové investice do síťové infrastruktury. Další možnosti jsou v použití RDMA přes konvergovaný Ethernet nebo Infiniband, což ale vyžaduje změny v síťové infrastruktuře.

Kvůli kompletnosti informací bych chtěl zmínit ještě jeden protokol, který sice nepatří k NVMe ale úzce souvisí s RDMA.

- SRP - SCSI RDMA protokol. SRP je protokol, který umožňuje SCSI komunikaci mezi zařízeními prostřednictvím RDMA (Remote Direct Memory Access). V tomto případě se vyžaduje pro RDMA specializovaný hardware jako jsou NIC pro Infiniband nebo síťové adaptéry s podporou roce nebo iWARP.

Pokud se osobně dívám na různé technologie NVMe a jejich nasazení z pohledu zákazníka tak mi napadá několik logických uzávěrů:

- Zákazníci, pro které je rychlý přístup k datům životně důležitý (z business perspektivy samozřejmě) již technologii NVMe v některé z jejích dostupných implementací mají nasazenou nebo ji plánují nasadit bez ohledu na náklady.

- Zákazníci, kteří mají SAN sítě páté nebo šesté generace a uvažují o zrychlení přístupu k datům mohou udělat změnu v kterékoliv vhodné chvíli (během technologické výměny staršího storage nebo serverového hardware) nakolik pravděpodobně z technického hlediska ostatní potřebné vybavení už mají.

- Zákazníci, kteří používají sítě LAN a nechtějí investovat do drahých DCB přepínačů si budou muset asi počkat na dodefinováním standardu NVMe / TCP, který jim umožní používat rychlost a výhody NVMe prostřednictvím standardních síťových LAN zařízení.

NetApp podporuje NVMe / FC (16Gbps a 32Gbps) na diskových polích FAS / AFF již od verze ONTAP 9.4 (v současnosti se nasazuje ONTAP 9.8), takže se jedná o již ověřenou technologii. Na diskových polích řady E / EF series je podpora NVMe protokolů mnohem širší, v nabídce je připojení přes vysokorychlostní Infiniband 100Gbps, RDMA přes konvergovaný Ethernet (RoCE v2) i 32Gbps NVMe / FC. Zbývá už jen na uživatelích, kdy se rozhodnou pro přechod na vyšší kvalitu připojení storage zařízení.

Rádi Vás u nás přivítáme a nabízíme Vám možnost provést PoC testování v prostorách společnosti ALEF.

Jan Vojtěch

NetApp BDM

cz-netapp@alef.com